Optimiser l’expérience utilisateur grâce à l’A/B Testing

Netflix, Amazon, Google… tous les designs de produits digitaux à fort trafic font l’objet d’expériences permanentes, souvent sans que l’on s’en aperçoive. L’idée derrière est simple : afin d’améliorer l’expérience utilisateur, tester en continu permet de s’affranchir des goûts et opinions subjectifs de chaque concepteur et de chaque utilisateur. Il faut prendre des décisions objectives et rationnelles. L’A/B Testing propose alors une méthode éprouvée, basée sur des statistiques récoltées auprès des utilisateurs, pour optimiser son produit digital. Si bien qu’aujourd’hui, selon la plateforme Kameleoon, 75% des sites ayant un trafic supérieur à 1 million de visiteurs font de l’A/B testing. Cet article va donc détailler comment l’A/B Testing sert à optimiser l’expérience utilisateur.

Pourquoi utiliser l’A/B Testing ?

L’A/B Testing permet de tester et comparer deux versions différentes d’une même page web. Cette méthode s’appuie sur les données utilisateurs pour déterminer ensuite quelle version obtient les meilleures performances.

L’A/B Testing est donc une méthode expérimentale : d’un côté une version « contrôle » du produit (la version A), et de l’autre côté la version testée (la version B). Ce procédé permet d’optimiser son produit par des améliorations incrémentales qui résultent de ces tests. En ce sens, il est important de préciser ce qu’est l’A/B Testing de ce qu’il n’est pas : il ne s’agit pas d’une méthode permettant la création globale d’un produit ; mais bien d’un processus qui permet d’optimiser un produit déjà en place, incrément par incrément. L’A/B Testing fonctionne par itération, s’appuyant systématiquement sur les données récoltées durant la période de test.

Dès lors, à quoi peut-on appliquer cette méthode ? En réalisé, tout – ou presque – peut être testé dans un produit digital. En revanche, pour maximiser son ROI, l’A/B Testing est surtout mis en place pour optimiser les conversions de leads : pages d’achat de site e-commerce, landing pages, annonces sponsorisées, mails, etc. Plus concrètement, l’A/B Testing est le plus souvent utilisé pour :

- Les boutons d’achat (« ajouter au panier »),

- Un call-to-action,

- Le remplissage d’un formulaire,

- L’inscription à une newsletter.

Modifier l’emplacement, la forme, la couleur ou l’intitulé d’un bouton, par exemple, peut permettre d’améliorer les conversions. Cette méthode souligne alors, par opposition, les conséquences que peuvent avoir un mauvais design sur le comportement des utilisateurs.

Les coûts d’acquisition d’audience étant globalement assez élevés sur un site de e-commerce, l’A/B Testing permet de générer plus de conversion à trafic constant.

Comment utiliser l’A/B Testing pour optimiser l’expérience utilisateur ?

1 – Fixer des objectifs et formuler des hypothèses

L’A/B Testing repose sur une méthode précise afin d’optimiser l’expérience utilisateur. La première partie, fondamentale, consiste à identifier ses objectifs et à formuler des hypothèses pour les atteindre. Ces hypothèses correspondent à des points potentiels d’amélioration sur le produit. Pour cela, la définition des objectifs et des hypothèses doit reposer sur une analyse précise des éléments suivants :

- Les données analytics récoltées par les données de navigation : taux de rebond, taux de conversion, panier moyen, etc. Cela permet d’identifier les axes d’amélioration lorsque ces KPIs se révèlent plus faibles sur une page donnée.

- Les données qualitatives récoltées lors de tests utilisateurs : retours utilisateurs, points de friction rencontrés, etc. Cette étape permet de comprendre les analytics récoltées et les attentes des utilisateurs.

A partir de ces données, nous pouvons émettre des hypothèses. Par exemple :

- Afin d’améliorer la conversion sur ma page d’achat, je dois modifier le bouton « Acheter », parce qu’il n’est pas assez incitatif pour l’utilisateur.

- Pour améliorer le taux d’inscription à la newsletter, je dois modifier le formulaire d’inscription, parce que cela demande trop de temps à l’utilisateur.

- Afin d’améliorer mon taux de rebond sur ma landing page, je dois modifier le call-to-action, parce qu’il n’est pas assez visible par l’utilisateur.

Cette première étape est clé dans le succès à venir de la campagne de tests : l’A/B Testing est avant tout un outil pour tester statistiquement des hypothèses. Si les hypothèses de départ sont mauvaises ou erronées, aucun résultat significatif ne sera obtenu.

Pour aller plus loin sur la formulation d’une hypothèse :

- VWO: How to Create a Strong A/B Testing Hypothesis?

- Optimizely: How to write a solid A/B test hypothesis

2 – Identifier les éléments à tester

Une fois l’hypothèse formulée, il faut définir la variable à modifier afin de créer deux versions différentes. L’A/B Testing étant une méthode incrémentale, les possibilités de changements sont nombreuses :

- Call-to-action : couleur, forme, intitulé, emplacement, icône…

- Formulaire : longueur des champs, nombre de champs requis, emplacement des champs…

- Titres : longueur, mots-clés, ton positif vs. négatif, déclaratif vs. interrogatif…

- Images : photographie vs. illustration, produit sur fond blanc vs. produit dans un environnement, personne seule vs. en groupe…

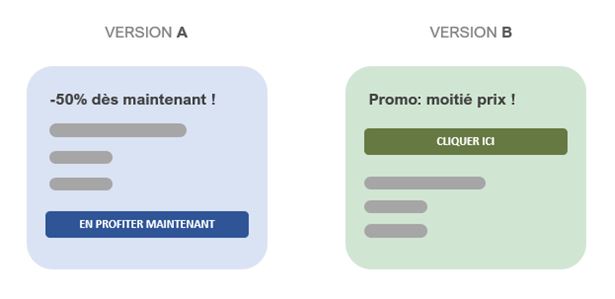

Pour que les résultats d’un test A/B soient significatifs, il est nécessaire de ne modifier qu’une seule variable à la fois : une couleur, une forme, un intitulé, un emplacement, etc… mais jamais plusieurs en même temps. Pourquoi ? Prenons l’exemple suivant :

Parmi les deux versions, plusieurs éléments ont été modifiés : couleur du fond ; couleur, intitulé et emplacement du call-to-action ; intitulé du titre. Si la version A présente de meilleures performances que la version B, comment savoir quelle modification en est à l’origine ? Est-ce le fond bleu qui fonctionne mieux que le fond vert ? Est-ce dû au titre de la version B qui serait plus incitatif que celui de la version A ? Il est impossible de savoir. Pire : à l’intérieur de chaque version, certains éléments peuvent avoir un impact positif et d’autres un impact négatif, sans possibilité de le détecter d’un point de vue statistique.

Le test multivarié (MVT) est alors l’unique façon de tester plusieurs variables à la fois. Si l’on choisit de tester deux couleurs différentes ainsi que deux intitulés différents d’un bouton d’achat, il faudra alors avoir 4 versions différentes :

Le MVT permet de tester plus rapidement certains éléments et d’avoir une connaissance plus précise du comportement des utilisateurs. En contrepartie, l’audience cible devra être beaucoup plus importante afin d’obtenir des résultats significatifs.

3 – Définir l’audience cible

L’analyse statistique des données demande d’avoir un trafic suffisant afin d’obtenir des résultats significatifs. Un résultat significatif signifie qu’il est très peu probable que le changement perçu soit dû au hasard : l’intervalle de confiance choisi est généralement de 95%. Plusieurs ressources permettent de calculer cette signification statistique :

Dès lors, la question se pose : quelle part de l’audience doit participer aux tests A/B ? Si l’ensemble de l’audience y participe, cela signifie que 50% verra la version A, et 50% verra la version B. Cela permettra d’avoir des résultats significatifs plus rapidement (car l’échantillon sera plus grand), cela signifie également que la moitié de l’audience verra une « mauvaise » version de la page. Si cette version obtient de mauvaises performances, il risque d’y avoir d’importantes répercussions sur la conversion. A l’inverse, pour atténuer ce risque, le test A/B peut alors n’être diffusé qu’à 20% de l’audience, par exemple. Le test devra alors être plus long afin d’atteindre un trafic suffisant pour obtenir des résultats significatifs.

Il est donc nécessaire d’effectuer un arbitrage entre la part de l’audience cible, le trafic minimum nécessaire à l’obtention de résultats significatifs et la durée du test.

Pour aller plus loin : Analytics-Toolkit: Statistical Significance in A/B Testing – a Complete Guide

4 – Mise en place des tests

Le paramétrage des tests s’effectue depuis une solution externe. A ce titre, plusieurs outils sont communément utilisés pour l’A/B Testing, notamment :

- Google Optimize

- AB Tasty

- VWO

- Kameleoon

L’objectif est fixé, l’hypothèse est formulée, les éléments à tester sont identifiés, l’audience cible est définie : il reste le temps d’exécution du test à paramétrer. Une bonne durée est généralement comprise entre deux à quatre semaines. Une semaine entière est un minimum, dans la mesure où les comportements des utilisateurs peuvent être différents entre la semaine et le week-end. Ensuite, tout dépendra de l’audience : plus l’audience sera grande, moins le test sera long.

5 – Analyse des données

La fin de la période de test s’accompagne de l’analyse des données récoltées : quelle version a enregistré la meilleure performance ? La performance est évaluée en fonction des objectifs fixés au départ : meilleur taux de conversion, meilleur taux de rebond, etc. Si une version présente des résultats positifs statistiquement significatifs, alors cette version devra être implémentée au sein du produit.

Il ne faut pas s’attendre à découvrir des résultats spectaculaires : cela peut occasionnellement se produire, mais ce n’est pas l’esprit de l’A/B Testing. Il s’agit d’une méthode d’optimisation, par petit pas. C’est en obtenant des résultats positifs, qui montrent des améliorations, certes faibles, mais statistiquement significatives, que l’on peut optimiser le produit.

En ce sens, conduire un seul test A/B sur un seul élément n’est pas pertinent. Cela doit s’inscrire dans une stratégie globale de tests A/B, avec une roadmap bien définie, pour que le produit global soit bien optimisé. Progressivement, par itération, élément par élément.

Limites de l’A/B Testing

Si l’A/B Testing permet d’optimiser son produit digital, il ne s’agit que d’un outil. Dès lors, il est nécessaire de comprendre que :

- L’A/B Testing ne peut se substituer à une réflexion approfondie des besoins utilisateurs : si les objectifs sont mal définis ou si les hypothèses de départ sont erronées, l’A/B Testing ne sera pas d’une grande utilité.

- L’effet du « local maximum » montre les limites de l’approche d’optimisation basée sur des données utilisateurs : à force d’effectuer des tests A/B sur une page, on atteint progressivement son maximum d’optimisation. Si l’optimisation ne peut qu’être positive, elle accapare parfois les ressources disponibles en lieu et place d’une véritable refonte du design qui pourrait avoir des effets plus positifs que ce maximum d’optimisation.

- L’A/B Testing donne des résultats, mais ne donne jamais d’explication sur le « pourquoi ». C’est la limite des approches data-driven : elles doivent aller de pair avec une recherche utilisateur pour comprendre leurs motivations.

- L’A/B Testing demande une audience importante afin d’obtenir des résultats significatifs. C’est donc un outil plus adapté aux produits digitaux à forte fréquentation.

- Le changement est incrémental, c’est-à-dire qu’on ne modifie pas le produit en profondeur. L’A/B Testing permet de modifier des éléments très simples d’un produit : un bouton, un intitulé, un formulaire, une illustration, etc. En ce sens, les changements apportés au design sont nombreux, mais mineurs à chaque fois : l’A/B Testing ne permet pas de refondre complètement un design.

Conclusion

L’A/B Testing est un outil très efficace pour optimiser l’expérience utilisateur de son produit digital. L’A/B Testing est une méthode incrémentale, qui fonctionne par itération : elle apporte beaucoup de changements, mais mineurs et parfois peu perceptibles. En prenant en compte les limites d’une telle méthode, et en l’utilisant pour les bonnes raisons, des résultats significatifs peuvent apparaître. Une stratégie globale de tests A/B, accompagnée d’une roadmap bien définie sont alors nécessaires pour mener à bien ce projet d’optimisation. HeadMind Partners, fort de son expertise, accompagne alors ses clients tout au long de ce processus.

Article écrit par Vincent CHAUVIN, Consultant, membre de la BCOM UX chez HeadMind Partners Business Consulting.

Retrouvez d’autres articles sur notre blog

Sources :

« 5 Steps to Quick-Start A/B Testing ». UX Booth [en ligne]. 2017. [consulté le 31/08/2021]. Disponible à l’adresse : https://www.uxbooth.com/articles/5-steps-to-quick-start-ab-testing/

« A/B and see: a beginner’s guide to A/B testing ». Invision [en ligne]. 2015. [consulté le 31/08/2021]. Disponible à l’adresse : https://www.invisionapp.com/inside-design/ab-testing-beginners-guide/

« Multivariate testing : gagnez du temps et affinez votre analyse ». Kameleoon [en ligne]. 2019. [consulté le 31/08/2021]. Disponible à l’adresse : https://www.kameleoon.com/fr/blog/ab-testing-test-mvt

« Qu’est-ce que l’A/B testing ». Kameleoon [en ligne]. [consulté le 31/08/2021]. Disponible à l’adresse : https://www.kameleoon.com/fr/ab-testing

« 7 steps of A/B testing ». UX Collective [en ligne]. 2018. [consulté le 31/08/2021]. Disponible à l’adresse : https://uxdesign.cc/7-steps-of-a-b-testing-what-how-cf3b209467fd

« Local Maxima in UX ». Interaction Design Foundation [en ligne]. [consulté le 31/08/2021]. Disponible à l’adresse : https://www.interaction-design.org/literature/topics/local-maxima-in-ux