La cybersécurité au cœur du salon AI Paris

AI Paris, le salon sur l’intelligence artificielle

Les 11 et 12 Juin, HeadMind Partners était partenaire du salon AIParis, qui rassemblait les acteurs de l’intelligence artificielle. Voici ce que nous avons retenu.

“La bataille de l’IA est d’abord une bataille pour l’intelligence humaine”, Cédric O, Secrétaire d’État chargé du Numérique.

La keynote d’ouverture de Cédric O., Secrétaire d’État chargé du Numérique, rappelle les investissements massifs dans la recherche et l’application de l’intelligence artificielle des Chinois et des Américains. Afin de peser dans la balance des enjeux politiques et économiques, il est important que l’Europe rentre dès maintenant dans la bataille, le risque étant de sortir de l’Histoire. La France a déjà dépensé plus de 1,5 milliard d’euros dans des projets d’intelligence artificielle et ce n’est qu’un début. Dans sa stratégie de développement, elle a choisi 5 domaines critiques pour l’utilisation de l’IA :

- La Santé, dont 2 des 5 plus grandes bases de données de santé internationales sont françaises

- L’industrie critique, à savoir les initiatives de maintenance prédictive, bâtiment autonomes, etc.

- La Cybersécurité

- L’énergie

- La mobilité, avec des projets de trains autonomes et de véhicules autonomes.

Cependant, la question de l’éthique se pose. Est-ce que des nations avec des valeurs contraires aux nôtres peuvent venir nous challenger ? Quels sont les impacts que peuvent introduire les biais cognitifs ? L’IA ne doit pas prendre de décision finale. Ce n’est qu’un assistant à la décision, une béquille pour soutenir l’Humain dans les décisions qu’il doit prendre.

Pour le domaine de la cybersécurité, de nombreuses avancées ont été constatées lors du salon. Avec 4 conférences et 5 ateliers, les enjeux de sécurité sont au centre des préoccupations des entreprises concevant ou consommant de l’IA.

L’ANSSI constate que l’IA peut être utile dans les mécanismes de sécurité…

Selon Vincent S., sous-directeur de l’expertise de l’ANSSI, la cybersécurité sera fortement impactée par l’IA dans les années à venir, incluant une transformation profonde des approches et des méthodes de détection des menaces. Les solutions d’intelligence artificielle au service de la cybersécurité sont en effet en plein essor. Pour la détection des menaces, l’intelligence artificielle semble être une bonne transition de l’approche classique (où on cherche à associer une attaque à une signature) vers une approche comportementale (où il devient possible de se prémunir contre des attaques non connues). Mais cette utilisation de l’IA semble trop complexe pour être pleinement efficace. La détection d’attaques informatiques est un problème ouvert, or, les techniques actuelles semblent montrer que l’IA est plus adaptée à répondre à des questions fermées.

…mais identifie également de nouvelles menaces…

L’intelligence artificielle induit de nombreuses difficultés et de nouveaux risques cyber auxquels les industriels doivent faire face et réfléchir.

Tout d’abord, il faut mettre en exergue l’estimation du niveau d’assurance sécurité. Les techniques actuelles d’IA laissent toujours un taux de faux négatif ou de faux positif significatif. Les conséquences d’un tel taux en cybersécurité sont importantes. Cela entraîne une mésestimation du niveau d’assurance sécurité qui peut être désastreux pour les entreprises.

Une autre difficulté liée au domaine de la cybersécurité est la sensibilité des données à traiter. Si par chance on arrive à détecter un attaquant, souvent on choisira de ne pas communiquer sur la méthode qui a permis sa détection.

Les attaques sont fortement évolutives et les attaquants ont prouvé qu’ils savent s’adapter à tout type de situation, y compris en utilisant eux même des techniques d’IA. Le challenge pour les défenseurs n’en est que plus complexe.

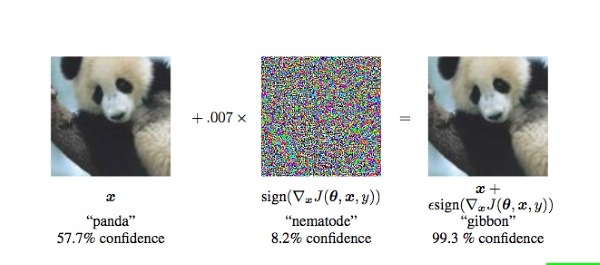

De plus, il est maintenant avéré qu’il est possible de tromper une IA via l’utilisation de biais sur des dispositifs de sécurité tels que la biométrie ou la reconnaissance faciale (un exemple ici). L’IA peut également être utilisée pour optimiser et perfectionner des méthodes d’attaques déjà existantes telles que le fuzzing, le reverse engineering ou les attaques par canaux auxiliaires.

Bien que de nombreux risques existent, les principales interrogations des conférenciers étaient orientées autour de deux risques suivants :

Risque 1 : La présence de biais inhérents ou voulus dans les modèles d’Intelligence Artificielle

Parmi les conférences, nous pouvons citer l’exemple d’IBM qui a développé des librairies de validation de biais. Bien que basées sur un nombre faible de biais identifiés, il est cependant intéressant d’identifier les premières initiatives sur le sujet. Egalement démontré par Axionable, il est possible, au travers d’une modification volontaire des données, de créer des biais quasi-indétectables par les mécanismes de data science. Ces biais permettent de modifier des modèles et donc de détourner l’objectif de base des IA pour obtenir des comportements malveillants.

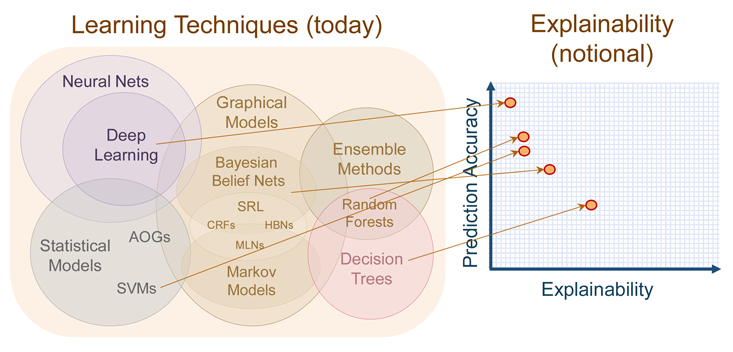

Risque 2 : L’inexplicabilité des modèles de Machine Learning

L’inexplicabilité, ou l’absence de raisonnement logique mis à disposition des utilisateurs pour identifier le cheminement de l’IA, est un risque majeur identifié par de nombreuses entreprises. Parmi les différents cas d’usages, celui de l’utilisation d’IA pour accorder ou non un crédit reste le plus discuté. L’impact d’une telle décision est si fort qu’il est nécessaire de pouvoir le justifier. Ainsi, les entreprises utilisant ces solutions exigent de connaître le raisonnement logique derrière ces refus ou acceptation générés par une IA.

De nombreuses recherches sur le sujet sont actuellement en cours, mais peu sont satisfaisantes. Dans la majorité des cas, les entreprises préfèrent utiliser des algorithmes pouvant justifier les choix des décisions (arbres de décision ou KNN), moins performant que les solutions utilisant des algorithmes complexes, tel des réseaux de neurones ou du deep learning.

… ainsi qu’un outil d’exception pour les attaques informatiques

Comme dans de nombreuses technologies, les hackers et organismes cybercriminels se situent dans les « early adopters » de la courbe de l’innovation. Que cela soit pour préparer une attaque, sa mise en place ou son exécution, de nouveaux outils malveillants intègrent dès à présent de l’IA.

Ce salon vient renforcer la conviction de HeadMind Partners, que les problématiques sécurité de l’intelligence artificielle, bien que faiblement étudiées, doivent être prises en compte. Entre impacts sociétaux forts et dépendance aux systèmes, les bonnes questions doivent émerger sur les enjeux cyber pour garantir un niveau de risque maîtrisé.

Co-écrit par Louis-Julien Go et Maxime Payraudeau, avec l’aide de Vaimiti Dupont.